利用AI 英伟达为汽车创建3D虚拟场景

[汽车之家 行业] 英伟达(Nvidia)公司宣布其在人工智能(AI)研究中取得突破,研究人员已经通过训练神经网络在真实的视频片段上来教人工智能系统如何生成和细节新的虚拟城市景观。该技术可为游戏、汽车、建筑、机器人或虚拟现实等快速创建虚拟世界。

在新的工作中,团队使用在DGX-1上的Nvidia Tesla V100GPU上运行的PyTorch深度学习框架,并在数千个Cityscapes视频和Apolloscapes数据集上培训它们。然后,研究人员将使用虚幻引擎4构建虚拟城市的基础,并强调建筑物、树木和汽车等事物的总体轮廓和布局。基于所学到的一切,神经网络填充空格,包括精细的细节、颜色、光照和纹理。

不同于需要用特定指令编程的传统算法,神经网络更像有机大脑,随着时间推移,从“经验”中学习。这种体验可以作为大型数据集馈送给系统,然后系统可以使用学到的规则来生成自己的内容。最近几年,它被用于将不同的艺术风格应用到视频中,基于对接下来会发生什么的预测从静止照片中创建短视频,以及生成额外的帧间帧以使得任何剪辑以慢动作发生。

英伟达研究人员利用神经网络,实时创建合成3D环境。与现在需要为虚拟世界中每个对象单独建模的方法相比,英伟达的方案更便宜、所需时间更短。

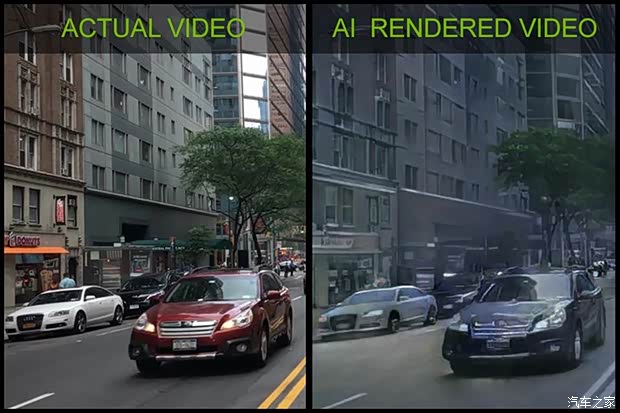

此次研究产生了一个简单的驾驶游戏,允许参与者在城市场景中进行导航,场景中的所有内容都使用神经网络,以交互式方式呈现,神经网络将传统图形引擎生成的3D世界的草图转换成视频。该神经网络已经学会模拟真实世界的状况,包括照明、材料和动态表现。

由于虚拟场景完全由人工合成而生成,因此可以轻松编辑、删除或是添加对象。研究人员表示,英伟达的Tensor Core图形处理器(GPU)使该演示成为可能。神经网络的工作原理是首先对场景进行高级描述,例如描述对象所处位置及其一般特征,如图像的特定部分是否包括汽车或建筑物,或者物体边缘的位置,然后神经网络会根据其在真实世界视频中学到的知识丰富详细信息。(消息来源:NEW ATLAS;编译/汽车之家 李娜)